Wichtiger Hinweis (Disclaimer): Dieser Beitrag stellt keine Rechtsberatung dar. Die hier dargestellten Informationen basieren auf öffentlich zugänglichen Quellen und unserer technischen

Copilot ist kein öffentlicher KI-Chatbot

Ein häufiger Irrtum:

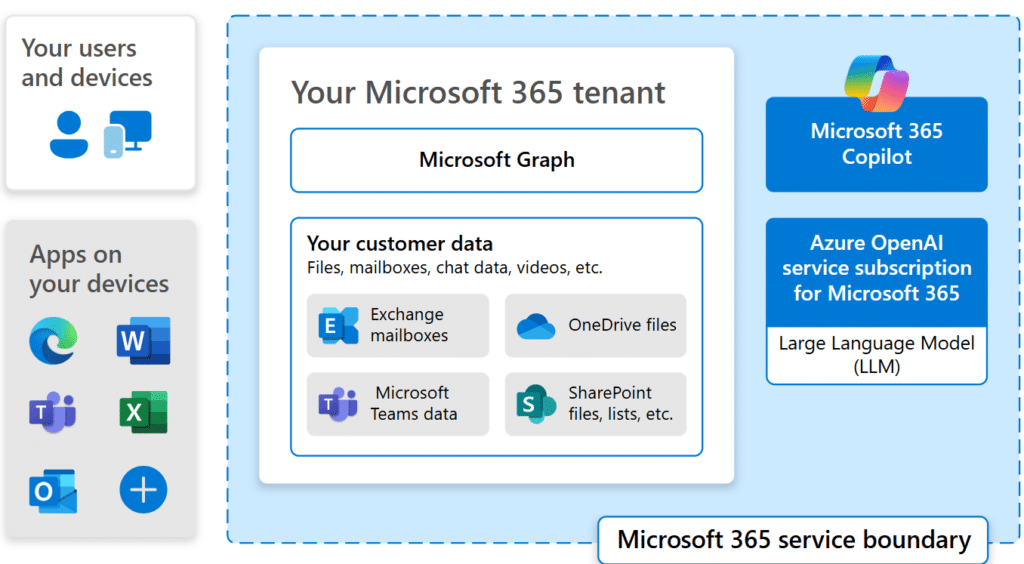

Das folgende Schaubild zeigt die Einbindung von

Was das konkret bedeutet:

Copilot hat einen umfassenden Zugriff auf die Daten Ihres Unternehmens: Das bedeutet, er greift auf Daten zu, für die die jeweilige Person im Unternehmen bereits berechtigt ist (hierbei ist es aber irrelevant, ob die Person eine Berechtigung zum Lesen oder Bearbeiten hat).- Inhalte werden nicht automatisch an Dritte weitergegeben

- Unternehmensdaten werden nicht für das Training der

KI -Modelle verwendet

Wir möchten bewusst betonen, wie Datenschutzportale zu dem Thema stehen: eRecht24 beispielsweise steht dem Thema allerdings kritisch gegenüber und schreibt über den Blackbox-Effekt, wonach „… sich nicht klar sagen lässt, wie generative

Aber: keine Sorge! Sie können dafür sorgen, dass Sie das Tool datenschutzkonform einsetzen.

Datenschutz- und Sicherheitsmechanismen von Copilot

Bevor wir zu den Maßnahmen kommen, die Sie selbst aufsetzen können, zeigen wir Ihnen zunächst, welche Vorkehrungen Microsoft bei

- Verschlüsselung: Daten werden verschlüsselt übertragen und gespeichert

- Zugriffskontrolle: Identitäts- und Zugriffskontrollen der Microsoft

Cloud gelten genauso fürCopilot - Audit- und Protokollfunktionen: Mit Tools wie Microsoft Purview können Sie nachvollziehen, wer was wann mit

Copilot gemacht hat

Allgemein orientiert sich die Datenverarbeitung an geltenden

Ist Microsoft Copilot DSGVO-konform? Die differenzierte Antwort

Kommen wir nun dazu, was Sie tun können, um

Wichtig für Unternehmen ist: Auch wenn Microsoft viele Schutzmechanismen liefert, liegt die rechtliche Verantwortung für den Einsatz beim Unternehmen selbst. Dies gilt nicht, weil

Warum ist das so?

In diesen Fällen liegt die Konfiguration und das Sicherheitsmanagement vollständig in der Verantwortung des Unternehmens.

Was Unternehmen konkret tun sollten:

- Klare Prozesse und Schulungen: Lassen Sie Ihr Team im Umgang mit

KI -gestützten Funktionen weiterbilden (insbesondere im Blick auf Risiken und personenbezogene Daten). Dies macht allein aus Haftungsgründen Sinn. - Prüfung, ob eine Datenschutz-Folgenabschätzung (DSFA) notwendig ist: In vielen Fällen kann eine Datenschutz-Folgenabschätzung (DSFA) gemäß Art. 35 DSGVO sinnvoll sein, insbesondere wenn

Copilot auf besonders sensible Informationen zugreift. Halten Sie dazu am besten Rücksprache zu Ihrer Rechtsberatung. - Einrichtung eines Rechtekonzepts: Sie sollten ein Rechtekonzept entwickeln, damit Nutzende keine Daten sehen können, zu denen sie nicht berechtigt sind und zu denen die

KI keinen Zugriff erhalten soll. - Vorsicht bei Verknüpfungen: Lassen Sie Vorsicht bei der Verknüpfung von

Copilot mit der Bing-Suche sowie mit weiteren Plugins und Drittanbieterdiensten im unternehmerischen Kontext walten. - Private E-Mail–Nutzung: Sofern die Mitarbeitenden das E-Mail-Programm auch privat nutzen dürfen, stellt sich das Problem dar, dass die

KI auch auf private Daten zugreifen kann. Allerdings hat der Arbeitgeber grundsätzlich kein Recht, auf private Inhalte des Arbeitnehmers zuzugreifen. Dies kann mit Strafen verbunden sein. - Richtige Einstellung (keine Leistungs-/Verhaltensüberwachung): Außerdem ist bei der Einrichtung darauf zu achten, dass der Zugriff durch

Copilot nicht zur Profilerstellung und damit zur Verhaltens- oder Leistungsüberwachung der Arbeitnehmenden eingesetzt werden kann. Dies ist datenschutzrechtlich problematisch und könnte das Vertrauen der Mitarbeitenden im Unternehmen beeinträchtigen. - Saubere Datenklassifikation: Definieren Sie genau, welche Daten wie verarbeitet werden dürfen (z. B. sensible vs. nicht-sensible Daten).

- Monitoring & Audits: Nutzen Sie Purview & Co., um Nutzung und Zugriff zu überwachen und bei Bedarf nachweisen zu können.

Fazit: Microsoft Copilot sicher und verantwortungsvoll einsetzen

Die Plattform ist von Grund auf darauf ausgelegt, datenrechtliche Anforderungen wie

Wir von anaptis können Unternehmen bei der sicheren Einführung und Nutzung von Dynamics 365 Business Central inklusive

loading="lazy" alt="microsoft-copilot-faq">

loading="lazy" alt="microsoft-copilot-faq">